ChatGPT a prouvé qu’il était capable de répondre aux questions des patients mieux que les vrais médecins (Image : Getty Images)

Les experts ont surnommé l’intelligence artificielle (IA) – les soins de santé augmentés « l’avenir de la médecine », car un chatbot s’est avéré capable de répondre aux questions des patients mieux que de vrais médecins. En fait, un panel de professionnels de la santé agréés a déclaré préférer les réponses de ChatGPT 79 % du temps, les qualifiant de « de meilleure qualité » et de « plus empathiques ». Bien que l’IA ne risque pas de remplacer votre médecin généraliste de sitôt, les chatbots pourraient fournir aux médecins un outil précieux pour les aider à faire face aux récentes augmentations de la communication numérique avec les patients, ont déclaré les chercheurs.

L’auteur de l’article et expert en santé publique, le professeur Eric Leas de l’Université de Californie à San Diego (UCSD), a déclaré : « La pandémie de COVID-19 a accéléré l’adoption des soins de santé virtuels.

« Bien que cela ait facilité l’accès aux soins pour les patients, les médecins sont accablés par un déluge de messages électroniques de patients demandant des conseils médicaux. »

Cela, a-t-il ajouté, a « contribué à des niveaux record d’épuisement professionnel des médecins ».

Dans leur étude, le professeur Leas et ses collègues ont cherché à savoir si le chatbot d’intelligence artificielle populaire d’OpenAI, ChatGPT, pourrait être appliqué de manière utile et sûre pour aider à alléger une partie de ce fardeau de communication croissant pour les médecins.

Pour évaluer ChatGPT, l’équipe a puisé des questions et des réponses dans « r/AskDocs » de Reddit (Image : Reddit)

Ce n’est pas la première fois que les applications potentielles de ChatGPT en médecine clinique sont explorées. En fait, une étude publiée dans la revue PLOS Digital Health plus tôt cette année a révélé que l’IA était capable de réussir les trois parties de l’examen américain de licence médicale.

Comme le dit le virologue de l’UCSD, le Dr Davey Smith – l’un des co-auteurs de la nouvelle étude – « ChatGPT pourrait être en mesure de réussir un examen de licence médicale, mais répondre directement aux questions des patients avec précision et empathie est un jeu de balle différent. »

Pour évaluer ses performances dans cette tâche, l’équipe s’est tournée vers « r/AskDocs » de Reddit, un sous-reddit comptant environ 452 000 membres où les gens posent leurs questions médicales réelles sur le forum et les médecins y répondent.

Alors que n’importe qui peut soumettre une question, les modérateurs du subreddit travaillent pour vérifier les informations d’identification de chaque médecin – qui sont incluses avec leurs réponses.

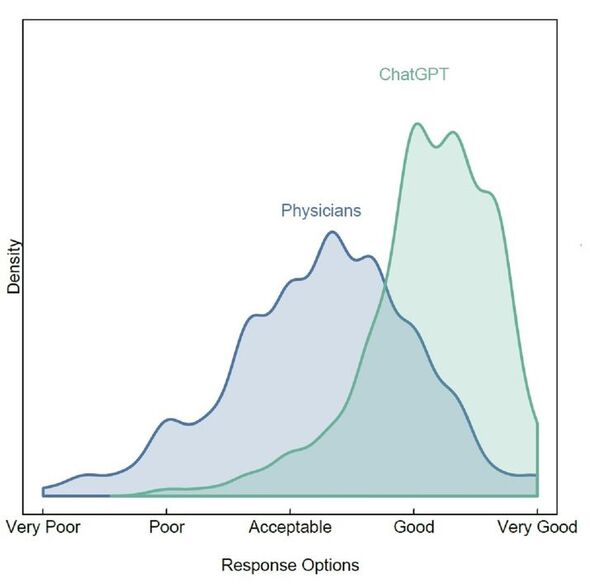

Le panel a évalué les réponses de ChatGPT comme « bonnes ou très bonnes » 3,6 fois plus souvent que celles des médecins (Image : Ayers et al. / Médecine interne JAMA)

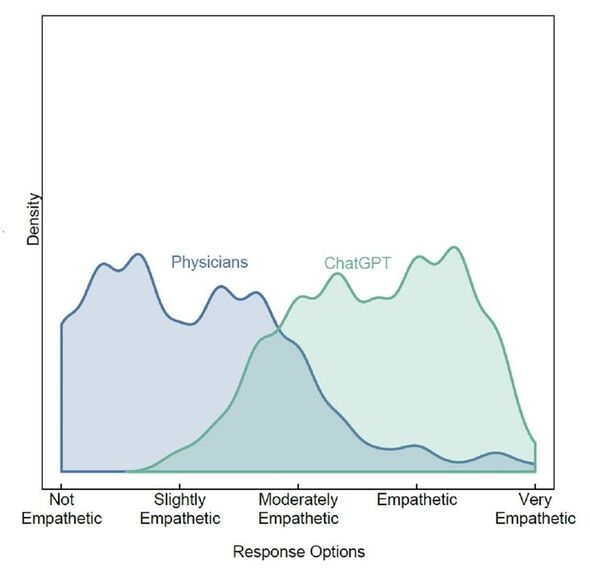

ChatGPT a été évalué comme «empathique ou très empathique» 9,8 fois plus souvent que les médecins (Image : Ayers et al. / Médecine interne JAMA)

Les chercheurs ont déclaré que ces échanges de questions-réponses reflétaient leurs propres expériences cliniques et fournissaient donc un « test équitable » pour ChatGPT.

En conséquence, l’équipe a échantillonné au hasard 195 échanges de questions-réponses entre le public et les médecins vérifiés – et a transmis la question à ChatGPT pour compiler une réponse.

Chaque question et les deux réponses ont ensuite été soumises à un panel de trois professionnels de santé agréés, qui – sans savoir quelle réponse provenait du chatbot et laquelle provenait d’un vrai médecin – les ont évalués pour la qualité de l’information et l’empathie.

Le panel a également indiqué laquelle des deux réponses il préférait.

Dans l’ensemble, l’équipe a constaté que le panel de professionnels de la santé préférait les réponses rédigées par ChatGPT 79 % du temps.

La co-auteure de l’article et infirmière praticienne Jessica Kelley de Human Longevity, un centre médical basé à San Diego, a déclaré : « Les messages ChatGPT ont répondu avec des informations nuancées et précises qui abordaient souvent plus d’aspects des questions du patient que les réponses des médecins.

Plus précisément, le panel a évalué les réponses du chatbot comme «bonnes ou très bonnes» en qualité 3,6 fois plus fréquemment que les médecins (à 78,5% contre 22,1%, respectivement).

ChatGPT a également été classé comme étant « empathique ou très empathique » 45,1 % du temps, contre seulement 4,6 % du temps pour les vrais médecins.

Le co-auteur de l’étude et hématologue de l’UCSD, le Dr Aaron Goodman, a commenté : « Je n’aurais jamais imaginé dire cela, mais ChatGPT est une ordonnance que j’aimerais donner à ma boîte de réception. L’outil transformera la façon dont j’accompagne mes patients.

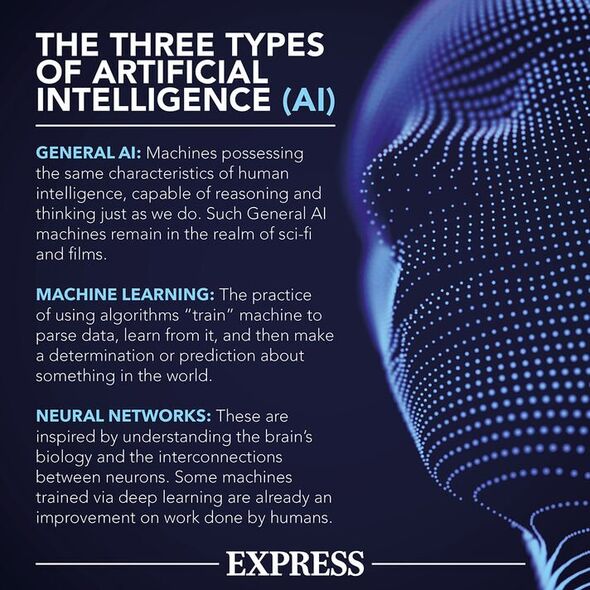

ChatGPT est construit sur une architecture de réseau neuronal (Image : Express.co.uk)

Le co-auteur de l’article et pédiatre, le Dr Christopher Longhurst, également de l’UCSD, a déclaré : « Notre étude est parmi les premières à montrer comment les assistants IA peuvent potentiellement résoudre des problèmes de prestation de soins de santé dans le monde réel.

« Ces résultats suggèrent que des outils comme ChatGPT peuvent rédiger efficacement des conseils médicaux personnalisés de haute qualité pour examen par les cliniciens. »

En effet, les chercheurs tiennent à souligner que le chatbot serait un outil à utiliser par les médecins – et non un substitut pour eux.

Le co-auteur de l’étude et informaticien, le professeur Adam Poliak, a déclaré : « Bien que notre étude oppose ChatGPT aux médecins, la solution ultime n’est pas de jeter votre médecin ensemble.

« Au lieu de cela, un médecin exploitant ChatGPT est la réponse pour des soins meilleurs et empathiques. »

L’auteur principal et épidémiologiste de l’UCSD, le Dr John Ayers, a conclu : « Les opportunités d’améliorer les soins de santé avec l’IA sont énormes. Les soins augmentés par l’IA sont l’avenir de la médecine.

Les résultats complets de l’étude ont été publiés dans la revue JAMA Internal Medicine.